le boîtier

On différencie les boîtiers par différents facteurs : Le format, la taille (et le nombre d'emplacements disponibles), l'alimentation (si présente), les ports disponibles en façade (audio, USB, FireWire, etc.) et la qualité des matériaux et assemblages.

Différents formats de boîtiers (appelés facteurs de forme) ont été conçus au fur et à mesure des années. De nombreux formats ont disparu petit à petit (AT, BTX). Seul l'ATX fait de la résistance.

Format ATX

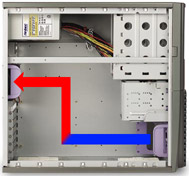

Successeur du format AT (créé en 1984), le format ATX (créé par Intel en 1995) permet une meilleure ventilation des périphériques internes et apporte aussi un gain de place. C'est le standard actuel qui n'a pas beaucoup évolué durant toutes ses années d'existence. Même le format BTX (créé en 2005 par Intel également) n'a pas réussi à prendre sa place. Ce format était destiné à mieux aérer les composants internes en jouant sur les flux thermiques.

Le format ATX 2.0 est une évolution du format ATX. Aujourd'hui, tous les boîtiers dits ATX sont en fait en ATX 2.0 et intègrent un connecteur carré 12V au niveau de la prise d'alimentation :

Une carte mère ATX a comme dimensions standard 12 * 9,6 pouces (30,5 cm * 24,4 cm).

Format Micro ATX

Le format micro ATX revoit les dimensions d'une carte-mère standard à 24.4 * 24.4 cm. Une carte-mère micro-ATX rentre dans un boîtier ATX, mais une carte-mère ATX ne rentre pas dans un boîtier micro ATX. Attention à votre carte-graphique si vous obtez pour un boîtier micro ATX : les cartes graphiques haut de gamme sont généralement très longues et peuvent ne pas rentrer dans le boîtier.

Format Mini-ITX

Le format mini ITX concerne principalement les plateformes à faible consommation d'énergie et de très faibles dimensions (17cm*17cm pour une carte-mère au format mini ITX). Ces plateformes peuvent être des mini PC ou encore des PC plats ne comportant pas de lecteur CD par exemple.

Les baies (emplacements pour les disques durs et lecteurs)

Un boîtier possède plusieurs emplacements pour pouvoir y stocker les périphériques (disques durs, graveur, etc.). Ce nombre varie en fonction de chaque boîtier. Les emplacements 3,5 pouces sont destinés aux disques durs et lecteurs de disquettes. Ceux-ci peuvent être internes ou externes. Quand ils sont internes, ils se trouvent à l'intérieur du boîtier et ne sont démontables qu'en ouvrant celui-ci.

Les emplacements 5,25 pouces accueillent les gros disques durs, les graveurs de CD ou bien les lecteurs de CDROM, de DVD, etc. Ce sont eux qui, en général, déterminent les dimensions d'un boîtier.

Formats et dimensions

En dehors de la norme (ATX, Etc.), il existe pour une même norme différents formats de tours :

- Mini tour : très utilisé avec les cartes mères micro-ATX, quelques baies 3,5 et au moins une de 5,25 pouces.

- Moyen tour : très utilisé avec les cartes ATX standards. C'est le format le plus utilisé. Il dispose de baies 3,5 et d'au moins 3 baies 5.25 pouces.

- Grande tour: pour les configurations avec plusieurs processeurs, plusieurs cartes graphiques et de nombreux disques durs en RAID grâce à beaucoup de baies 5.25 pouces (au moins 5) et 3.5 pouces.

Il existe aujourd'hui les Mini-PC (aussi appelés Barebones) qui sont les plus petits boîtiers jamais conçus, ils disposent la plupart du temps de deux emplacements 5,25 pouces et de deux emplacements 3,5 pouces (l'un étant interne, l'autre externe).

Refroidissement

Aujourd'hui, un bon ventilateur sur son processeur ne suffit pas forcément. Bien que les constructeurs de processeurs soient maintenant adeptes de la performance par watt et proposent des processeurs de plus en plus économes en énergie, il reste nécessaire d'évacuer la chaleur produite par ces composants de plus en plus puissants, et de plus en plus confinés dans des coques aux faibles dimensions s'intégrant de plus en plus à notre vie quotidienne.

Si vous disposez de 2 disques durs ou plus dans votre machine, il est nécessaire de les ventiler pour préserver leur durée de vie, surtout s'ils sont côte à côte.

Une fois que l'air frais est entré par l'avant, il faut l'évacuer. Il est préférable de créer une dépression dans le boîtier, autrement dit, mettre un ventilateur de plus en extraction. Cependant, il ne faut pas ajouter trop de ventilateurs, le niveau sonore deviendrait alors trop envahissant pour être supportable. Il faut placer les ventilateurs de telle sorte que les ventilateurs situés en haut extraient l'air chaud du boîtier vers l'extérieur, tandis que les ventilateurs situés en bas alimentent le boîtier en air frais. Vous pourrez si vous souhaitez refroidir plus efficacement vos composants opter pour d'autres solutions de refroidissement, comme le Watercooling (refroidissement par eau) par exemple.

Matériaux, qualité d'assemblage et finition

élement important mais très souvent négligé ou oublié (à tort) par l'acheteur, la qualité du boîtier se révèle être essentielle. Bien souvent, les gens souhaitent une configuration haut de gamme et sont donc prêts à y mettre le prix, en revanche ils refusent d'investir un peu d'argent dans un boîtier digne de ce nom. Et pourtant, il y a de nombreuses différences entre un boîtier à 40 euros et un autre à 150 ! D'une part, la structure en elle-même est nettement plus soignée sur les boîtiers haut de gamme.

Les boîtiers les plus chers sont généralement en aluminium, alors que ceux d'entrée de gamme sont principalement en acier et en plastique.

Il vous sera quasiment impossible de plier un boîtier bien conçu (et donc cher) mais vous serez également assuré(e) de pouvoir monter vos composants sans forcer comme un(e) demeuré(e) au risque de les abîmer.

L'alimentation si elle est fournie sera également de bien meilleure qualité et pourra vous rendre service dans le futur en servant de fusible entre le courant EDF et votre carte-mère, contrairement à ce qu'il se serait passé avec une alimentation bas de gamme qui aurait pu claquer directement (et faire fumer votre carte-mère avec).

Le montage de votre PC sera également grandement facilité avec un boîtier bien conçu, car ils intègrent généralement des mécanismes permettant de monter les lecteurs de disques durs ou de DVD Rom en les clipsant, sans vis. Ces systèmes offrent une bonne résistance et permettent en plus d'éviter les vibrations, ce qui ne peut que rendre la configuratin plus silencieuse.

Pour réduire le bruit, il existe des boîtiers livrés avec un potentiomètre ou interrupteur agissant sur la vitesse des ventilateurs.

Alimentation

L'alimentation permet de fournir du courant électrique à tous les composants de l'unité centrale. Elle est aujourd'hui plus importante qu'hier : en effet avec la montée en fréquence des processeurs et cartes graphiques, la demande en courant s'accroît au fur et à mesure des années. Un processeur fonctionnant à 3 GHz consomme près de 70 A, et les nouveaux processeurs peuvent consommer plus de 120 Watt !

Une alimentation délivre 3 tensions principalement : 12V, 5V et 3,3V. Elle délivre aussi des tensions négatives : -12V, -5V, et -3,3V qui ne délivrent pas beaucoup de puissance.

Il existe des alimentations dont la ventilation est thermorégulée : pour faire le moins de bruit possible, la vitesse du ventilateur varie en fonction de la température de l'alimentation. Plus elle chauffera, plus il tournera vite et inversement.

La puissance idéale se situe aujourd'hui à 600W pour une configuration de gamer. Vous pouvez réduire cette puissance à 450Watt avec une configuration bureautique. Ce niveau de puissance est largement suffisant pour tout type d'usages. L'avantage de prendre une alimentation très puissante est qu'elle fera généralement moins de bruit qu'une petite alimentation utilisée à son maximum, la durée de vie en sera d'ailleurs améliorée.

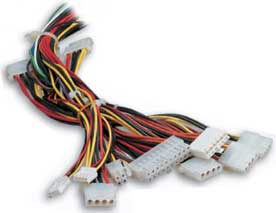

Il peut y avoir jusqu'à cinq types de connecteurs sur une alimentation :

- Celui de la carte-mère, qui est rectangulaire et possède une vingtaine de fils.

- Les prises Molex, qui alimentent les périphériques 3,5 pouces et 5,25 pouces.

- L'alimentation du lecteur de disquette.

- L'alimentation des disques durs SATA.

- Le branchement des façades lumineuses ou encore de ventilateurs intégrés au boîtier.

Le nombre de ces connecteurs varie d'une alimentation à l'autre : plus elle sera puissante et plus elle en disposera.

L'alimentation est devenue un périphérique à part entière. Souvent intégrée directement au boîtier quand vous achetez celui-ci, vous pouvez aussi vous en procurer une séparément. Et il en faut toujours plus : entre la dernière carte graphique à la mode ou les derniers processeurs quadcores, la demande en terme d'énergie est de plus en plus forte, et l'exigence en terme de stabilité des tensions des nouveaux périphériques ne cesse de s'accroître au fur et à mesure que leur finesse de gravure augmente.

Le marché des alimentations PC s'est adapté. De simples boîtes grisâtres, nous sommes passés à de jolis produits lumineux et colorés. Tout cela est bien beau, mais comment ça fonctionne ? C'est ce que nous allons tenter de voir maintenant au travers d'explications simples.

Tension alternative - tension continue

Une alimentation doit fournir plusieurs tensions à partir d'une même source, à savoir la prise 230V.

La tension qui sort de la prise est dite alternative car elle ne garde pas la même valeur au cours du temps (contrairement à une tension continue, qui garde à peu près la même valeur constamment). Le premier but de l'alimentation est de convertir le signal 230 Volts alternatif en signal 12 Volts continu :

La première étape consiste généralement à utiliser un pont de diodes pour redresser la tension. Le redressage consiste à transformer les alternances négatives en alternances positives (une diode est un composant électronique ne laissant passer que les alternances positives du courant). Voici à quoi ressemble le signal une fois qu'il a passé une diode :

Afin de redresser complètement le signal, on va placer une deuxième diode qui va permettre (en combinaison de la première) d'effectuer un redressage complet du signal :

Le découpage

Nous avons à ce stade redressé complètement le signal, mais il est encore loin d'être continu ! Voici le schéma montrant le principe de fonctionnement d'un pont de diodes, aussi appelé pont de Graëtz :

La tension est ensuite lissée pour se rapprocher le plus possible d'une tension continue. Une fois celle-ci obtenue, il va falloir à partir de cette source de 12V obtenir deux autres niveaux de tensions qui sont 5V et 3.3V.

Pour ce faire, elle utilise ce qu'on appelle le découpage. Le découpage consiste à faire varier le rapport cyclique du signal de manière à obtenir une valeur moyenne différente. Qu'est-ce que le rapport cyclique ? Prenons l'exemple de ce signal :

le rapport cyclique est égal à Ton / (Ton + Toff), la somme Ton + Toff étant la période du signal souvent notée T. Le rapport cyclique est toujours compris entre 0 et 1. La valeur moyenne du signal obtenu va déterminer la tension en sortie. Si on souhaite obtenir du 6V à partir de 12V, on aura donc à choisir un rapport cyclique de 0.5.

Bien choisir son alimentation

Bien choisir son alimentation est important. En effet, l'alimentation va souvent déterminer le niveau d'évolutivité de votre PC ainsi que sa stabilité. évitez donc à tout prix des alimentations dites no name (sans marque) et préférez des produits de constructeurs reconnus, comme par exemple Enermax, Antec ou encore Fortron. Une alimentation no name ne disposera généralement pas d'un fusible de sécurité permettant de sauver le reste de votre configuration en cas de surintensité.

La puissance délivrée par une alimentation est très variable. Ne vous laissez pas avoir par les emballages des constructeurs. Quand l'alimentation est donnée pour 400 Watts sur l'emballage, il est rare qu'elle en délivre plus de 350 non stop (et rend généralement l'âme). Préférez une alimentation de 400 Watts délivrant vraiment 400 Watts qu'une alimentation affichée comme 600 Watts et qui lâchera dès que vous tirerez 250 Watts dessus.

Le rendement d'une alimentation est également très important. Lorsque vous tirez 600 Watts de la prise de courant, votre PC consomme mettons 500 Watts, les 100 Watts restants sont perdus par l'alimentation. Le rendement se définit comme suit : Rendement = Puissance utile / Puissance consommée. Il est toujours inférieur à 1 (car il existe toujours des pertes). Plus le rendement se rapproche de 1 (et donc de 100%) et meilleure est l'alimentation. Il existe une norme intitulée 80 plus :

************************************

La carte-mère est en fait le système nerveux du pc. C'est sur elle que sont connectés tous les éléments du pc. Son choix est primordial si vous souhaitez pouvoir faire évoluer votre configuration à moindre coût. Une bonne carte-mère vous permettra également de profiter au maximum de vos périphériques qui ne seront pas limités par une carte-mère peu performante. Nous allons maintenant voir de quoi est composée une carte-mère, et pourquoi les éléments qui la composent sont si importants.

Le chipset :

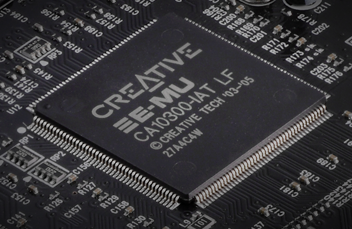

Le chipset (aussi appelé jeu de composants) est la plateforme centrale de la carte. Il va coordonner les échanges de données entre le processeur et les divers périphériques. Sans un bon chipset, votre PC ne pourra évoluer facilement et à moindre coût. Certains chipsets intègrent une puce graphique, audio, réseau, modem, etc. Cela veut dire qu'il n'est pas nécessaire d'acheter ces composants car ils se trouvent déjà sur la carte-mère, soudés. Toutefois, mieux vaut désactiver ces composants généralement peu performants (surtout en ce qui concerne les chipsets graphiques, bien que les progrès des chipsets dernières générations soient notables) et en installer de véritables. Cela coûtera plus cher mais vous ne le regretterez pas. Voici un diagramme d'un chipset, on y distingue le northbridge et le southbridge :

C'est également lui qui va vous permettre de bénéficier de fonctions très intéressantes qui ne sont pas disponibles sur tous les chipsets. Voici quelques fonctions intéressantes :

Le SATA :

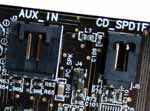

Aujourd'hui presque tous les chipsets modernes intègrent un contrôleur SATA (Serial ATA). Cette interface apparue en février 2003 utilise un bus série (contrairement au PATA pour Parallel ATA qui lui utilise un bus parallèle). La bande passante (quantité de données que peut transporter un bus en un temps donné) de cette interface est plus élevée que le PATA : le SATA permet de transporter les données à 150 Mo/s, et même 300 Mo/s dans sa première révision qui porte le nom de SATA II. Le SATA utilise des connecteurs plus fins que l'IDE (il n'a besoin que de 4 fils pour fonctionner contrairement aux dernières nappes IDE nécessitant 80 fils, cependant le connecteur en comporte 7).

Un connecteur SATA :

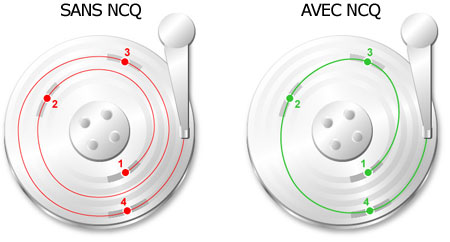

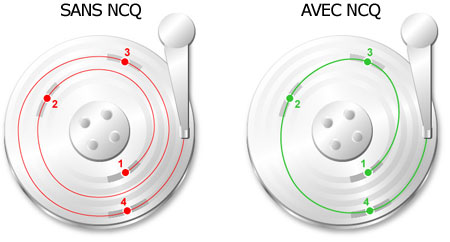

Le NCQ (native command queueing) :

Le NCQ est une technologie destinée à améliorer les performances des disques durs. Cette technique permet de réorganiser l'ordre des requêtes envoyées au disque dur pour que celui-ci récupère les données en faisant le moins de tours possibles pour récupérer les données demandées (ce qui se fait donc plus rapidement). Cette technologie n'est efficace que si vous ne parcourez pas un seul gros fichier non fragmenté sur le disque et est implantée dans les chipsets les plus récents :

Le RAID :

Le RAID est de plus en plus intégré dans les cartes-mères. Que ce soit RAID 0, RAID 1 ou parfois d'autres niveaux de RAID, il faut savoir que la plupart des cartes-mères (pour ne pas dire toutes) intègrent un contrôleur RAID semi-hardware. C'est important de le souligner : ce n'est pas pareil qu'un vrai contrôleur raid. C'est aussi pour ça que vous avez entre autres besoin d'appuyer sur F6 et d'insérer des pilotes lorsque vous installez Windows XP avec un système RAID SATA par exemple... Les performances (bien que largement suffisantes) sont légèrement inférieures à celles offertes par une vraie carte contrôleur car le pourcentage du processeur utilisé est supérieur (étant donné que la partie "logiciel" gère aussi le RAID, il y a une perte de performances inhérente à ce système).

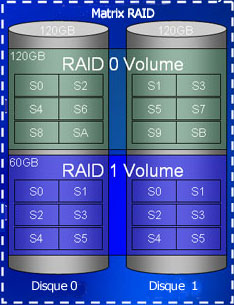

Le Matrix RAID :

Le Matrix RAID est une technologie présente sur quelques cartes-mères Intel. Cette techologie permet d'avoir différents niveaux de RAID en utilisant les mêmes disques. Vous pouvez ainsi utiliser un RAID 0 pour les performances et y installer le système d'exploitation, tout en utilisant un RAID 1 pour vos documents par exemple, et tout ceci en utilisant simplement deux disques !

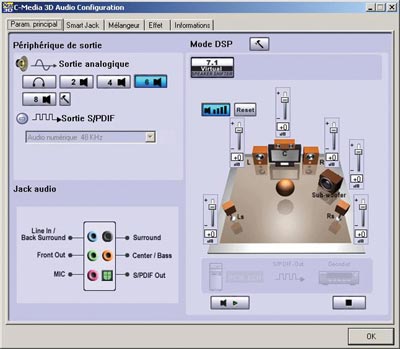

L'High definition audio :

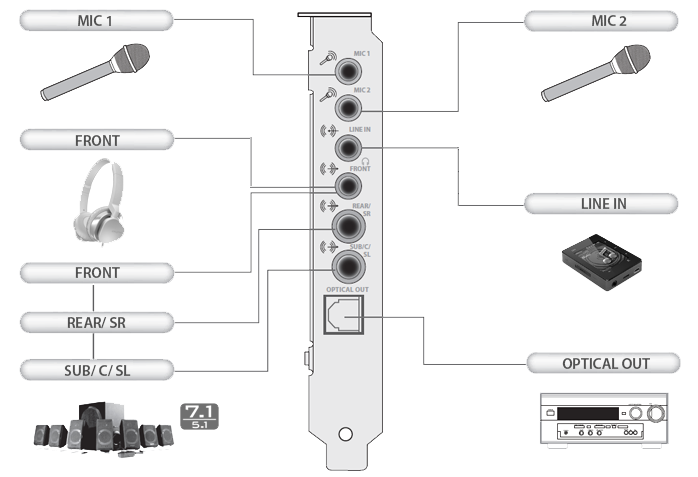

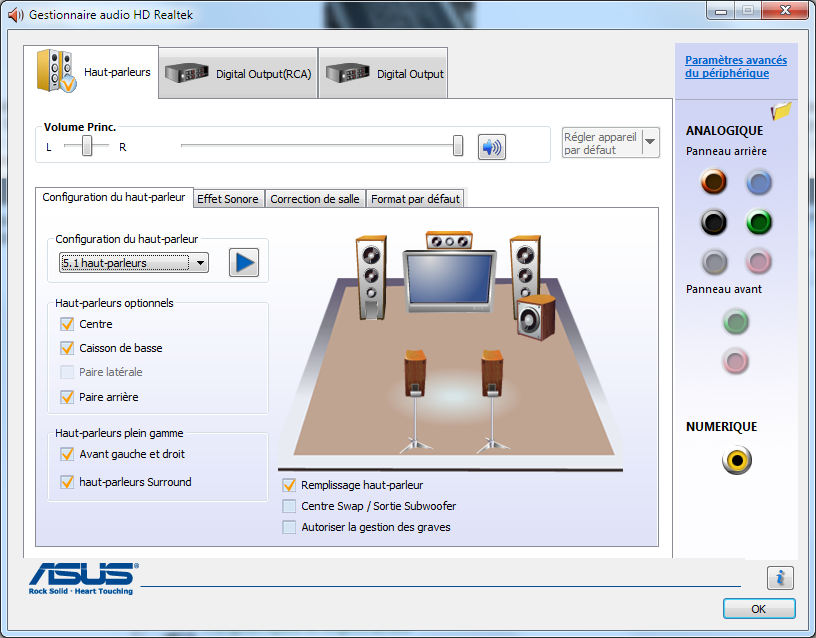

Inventée par Intel, cette technologie vise à détrôner l'AC 97 (norme utilisée par presque tous les anciens chipsets son intégrés, hormis ceux utilisant un chipnet Nforce 2 et supérieurs). Cette technologie supporte d'office le son 7.1 (ce qui n'était le cas que sur de rares chipsets avec l'AC 97). Cette technologie supporte le son 24 bit 192 KHz (il faudra d'ailleurs le supporter sans quoi une carte mère ne pourra se voir attribuer cette "norme"). Voici à quoi peut ressembler le panel de gestion :

Le PCI express :

Développé par Intel, ce nouveau bus est destiné à remplacer les bus PCI et AGP. Lors de sa sortie, le gain de performances par rapport à l'AGP était inexistant. C'est désormais fini aujourd'hui, les cartes graphiques étant maintenant capables d'en exploiter toute la bande passante. Le bus PCI express est un bus série, chaque "X" signifie que le bus peut transporter 250 Mo/s de données. Il existe différentes vitesses et différents ports associés pour le PCI express :

- Le PCI Express 1X : sa bande passante est de 250 Mo/s (presque le double de celle du bus PCI)

- Le PCI Express 2X : sa bande passante est de 500 Mo/s

- Le PCI Express 4X : sa bande passante est d'1 Go/s

- Le PCI Express 8X : sa bande passante est de 2 Go/s

- Le PCI Express 16X : sa bande passante est de 4 Go/s (le double de celle de l'AGP 8X)

L'USB 2 :

L'USB 2 est destiné à remplacer l'USB (Universal Serial Bus), c'est chose faite dans toutes les cartes-mères récentes. Il existe plusieurs normes d'USB 2 : l'USB "Full speed" qui en fait n'est qu'un leurre marketing car il fonctionne à la même vitesse que l'USB (1.5 Mo/s). Le "vrai" USB 2 est dénommé "High Speed" et fonctionne quant à lui à 60 Mo/s maximum, soit 40 fois plus que l'USB 1. Il s'agit d'un bus série. 4 fils sont nécessaires pour le faire fonctionner : deux pour l'alimentation (+5V et la masse aussi appelée GND pour Ground) et deux autres pour les données (D+ et D- pour Data+ et Data-).

Le BIOS :

Le BIOS (Basic Input Output System) est présent sur toutes les cartes-mères. Il permet au PC de booter (démarrer) et d'initialiser les périphériques avant de passer le relais au système d'exploitation (Windows, Linux...). Tous les BIOS ne se valent pas, ainsi il est fréquent de ne pas pouvoir avoir accès aux fonctions avancées du BIOS sur un PC de grande marque (réglage de la vitesse du processeur, de son voltage, désactivation de périphériques intégrés...). Le BIOS est généralement situé dans une puce programmable d'EEPROM qui est une mémoire morte effaçable et reprogrammable, les paramètres du BIOS étant eux stockés dans une mémoire CMOS qui a besoin d'être alimentée pour conserver ses informations, c'est pourquoi une pile plate figure sur la carte-mère.

Différenciation des cartes-mères :

On différencie généralement les cartes-mères par leur :

- facteur d'encombrement (ATX, micro ATX... voir l'article sur le boîtier)

- Chipset

- Support de processeur (appelé socket)

- Fonctionnalités intégrées.

Le facteur d'encombrement :

Ce sont en fait les normes qui définissent les dimensions et la forme géométrique de la carte-mère. Il existe différents facteurs d'encombrement tel que :

- ATX, qui est le plus répandu aujourd'hui

- AT, ancêtre de l'ATX, presque totalement disparu aujourd'hui

- Baby AT, comme ci dessus, gère des cartes-mères plus petites

- Micro ATX, format bien connu de certains barebones (mini PC)

L'horloge temps réel :

C'est un circuit chargé de la synchronisation des signaux du système. Elle est constituée d'un cristal qui, en vibrant, donne des impulsions afin de cadencer le système. On appelle fréquence d'horloge le nombre de vibrations du cristal par seconde. Plus la fréquence est élevée, plus le système pourra traiter d'informations. Cette fréquence se mesure en MHz. 1 MHz équivaut à 1 million d'opérations par seconde.

La pile du CMOS :

Lorsque vous éteignez l'ordinateur, il conserve l'heure et tous les paramètres qui lui permettent de démarrer correctement. Cela vient d'une pile plate au format pile bouton. Le CMOS est une mémoire lente mais qui consomme peu d'énergie, voilà pourquoi on l'utilise dans nos PC alimentés par des piles à l'arrêt. Si l'heure de votre PC commence à retarder ou si elle change brutalement, changez la pile. Enlever la pile permet aussi de restaurer les paramètres par défaut du BIOS. Si vous avez touché au BIOS et que par malchance votre PC ne démarre plus, enlevez puis remettez la pile peu de temps après.

Les ports PCI, AGP et PCI Express, et les fréquences de bus associées :

Une carte-mère comporte un certain nombre de ports destinés à connecter différents périphériques. Voici les plus connus :

- Le port PCI : Cadencé à 33 MHz et pouvant transporter 32 bit de données par cycle d'horloge (64 sur les systèmes 64 bit), le port PCI est encore utilisé dans les configurations les plus récentes. Il n'est trop lent que pour les cartes graphiques, lesquelles utilisent un port encore plus rapide, le port AGP ou le port PCI Express (encore plus rapide).Voici différents débits du port PCI en fonction de sa fréquence et de la largeur du bus de données (on prendra 1Mo = 1024 octets):

- PCI cadencé à 33 MHz en 32 bit : 125 Mo/s maximum

- PCI cadencé à 33 MHz en 64 bit : 250 Mo/s maximum

- PCI cadencé à 66 MHz en 32 bit : 250 Mo/s maximum

- PCI cadencé à 66 MHz en 64 bit : 500 Mo/s maximum

- Le port AGP : Il a un bus plus rapide que le bus PCI (allant jusqu'à 64 bit et 66 MHz). Il existe en différentes versions : AGP 1x (250 Mo par seconde), AGP 2x (500 Mo par seconde, il ne change pas de fréquence mais exploite deux fronts mémoire au lieu d'un, un peu comme laDDR, AGP 4x (1 Go par seconde, qui dédouble encore les données) puis l'AGP 8x (2 Go/s maximum) présent maintenant dans toutes les cartes-mères supportant encore l'AGP (place est donnée au PCI Express maintenant).

- Le port PCI Express : allant de 250 Mo/s pour le PCI Express 1X, les débits de ce bus peuvent monter à 4 Go/s en mode 16X. C'est le remplaçant des bus PCI et AGP (voir plus haut pour les spécifications de vitesses).

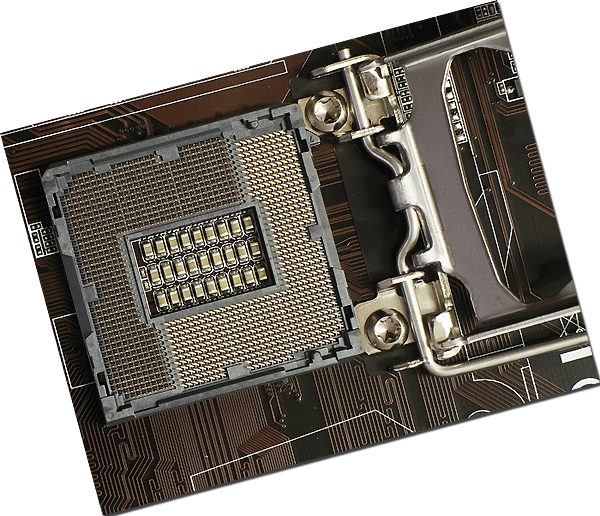

Le socket :

Le port destiné au processeur (socket) ne cesse d'évoluer. Il est passé du socket 7 (processeurs Pentiums), au slot 1 chez INTEL et au slot A chez AMD. Mais il fait un retour en force, sous forme de socket 478 et 775 chez INTEL et socket 462 puis 939 chez AMD. Les chiffres correspondent au nombre de trous du socket.

Quelques bus :

Un bus est un circuit intégré à la carte-mère qui assure la circulation des données entre les différents éléments du PC ( mémoire vive, carte graphique, USB, etc...). On caractérise un bus par sa fréquence (cadence de transmission des bits) et sa largueur (nombre de bits pouvant être transmis simultanément).

- Le bus système : appelé aussi FSB pour Front Side Bus, c'est le bus qui assure le transport de données entre le processeur et la mémoire vive. Il est généralement cadencé à 800 MHz chez Intel (1066 MHz également) en QDR (quad data Rate, en fait le bus n'est cadencé qu'à 200 MHz et 266 MHz pour 800 MHz QDR et 1066 MHz QDR). Chez AMD le FSB monte à 400 MHz DDR (200 MHz réels).

- Le bus série : c'est le bus que tous les PC possèdent, celui qui débouche sur le port servant à brancher une souris ou un modem, ou encore certains périphériques de jeux. Ses défauts sont sa lenteur extrême car les données ne sont envoyées que bit par bit ( 0 ou 1 ).

- Le bus parallèle : c'est le bus qui communique avec le port parallèle, qui sert à brancher l'imprimante, le scanner, des graveurs externes, etc... Il est 8 fois plus rapide que le port série ( les informations sont transmises par tranche de 8 bit en parallèle, soit 1 octet à la fois), mais toujours lent si on le compare aux bus USB et FIREWIRE.

- Le bus USB (Universal Serial Bus ) : il est largement plus rapide que le bus parallèle et peut aller à la vitesse de 1.5 Mo par seconde pour l'USB 1.1. L'USB 2.0 peut quant à lui monter à 60 Mo par seconde ! Il est relié au port USB qui sert à brancher presque tous les périphériques du marché : webcams, modems, imprimantes, scanners, manettes de jeu... Son avantage est de pouvoir en théorie brancher 127 périphériques !

- Le bus FIREWIRE : il permet de brancher 63 périphériques et offre des caractéristiques semblables à l'USB, en beaucoup plus performant : le bus FIREWIRE permet d'atteindre de 25 à 100 Mo par seconde ! Ses défauts sont que les périphériques qui se branchent sur ce type de port sont rares (et chers).

- Le bus ISA (industry standard architecture ) : c'est le bus archaïque du PC avec le port série ! il fonctionne en 8 bit ( 1 octet ) pour les ordinateurs anciens, ou 16 bit pour les ordinateurs récents disposant encore de ce type de bus. Son taux de transfert est d'environ 8 Mo par seconde pour le 8 bit et 16 Mo par seconde pour le 16 bit.

- Le bus PCI (peripheral component interconnect) : c'est le bus qui tend à être remplacé avec l'AGP par le bus PCI Express.

- Le bus AGP (accelerated graphic port) : Il est apparu avec le pentium II en 1997. Il permet de traiter 32 bit à la fois et à une fréquence de bus de 66 MHz. Ses qualités sont sa rapidité (500 Mo par seconde pour le 2 X et 1 Go pour le 4 X, et maintenant 2 Go par seconde pour le 8x). Il communique avec le port AGP.

- Le bus PCI Express : allant de 250 Mo/s à 4 Go/s via ses nombreuses déclinaisons (1X, 2X, 4X, 8X, 16X) il va remplacer à terme les bus PCI et AGP.

Bien choisir une carte-mère est quelque chose de très important. En effet, tous les périphériques internes sont reliés à elle. L'évolutivité de votre configuration devient donc tributaire d'un seul élément, la carte-mère ! Voici les quelques éléments de base que auxquels vous pouvez vous intéresser si vous souhaitez acheter une carte-mère :

Le facteur d'encombrement : Les cartes-mères sont aujourd'hui toutes au format ATX (ou des dérivés de l'ATX), il en existe d'autres au format BTX (certaines cartes-mères pour processeurs INTEL au format Socket T). Choisissez votre carte-mère en fonction de l'usage auquel vous allez destiner votre PC et aux performances attendues. Une carte-mère pour barebone sera forcément moins évolutive qu'une bonne carte-mère ATX.

Le chipset : Il doit au moins gérer le SATA et la mémoire DDR PC 3200 avec un bus USB 2. C'est un minimum. Mais des fonctions telles que le réseau ou le son sont les bienvenues. Ne pas oublier le chipset graphique qui peut éviter d'avoir à acheter une carte graphique si vous n'êtes pas joueur. Attention à l'évolutivité cependant, et regardez que la carte-mère soit équipée d'un port AGP ou PCI Express 16X pour pouvoir désactiver le chipset graphique intégré le jour où vous voudriez jouer à autre chose qu'au solitaire ou à des jeux 3D anciens.

Nombre de ports : une carte-mère avec 2 ports DIMM pour la mémoire est un minimum.

Prix : inutile d'acheter une carte-mère avec un chipset très haut de gamme qui n'apporte généralement pas grand chose au niveau des fonctionnalités utiles à l'utilisateur. Préférez les cartes milieu de gamme qui généralement ont un aussi bon chipset au niveau des performances, mais rognent un peu sur les gadgets, le tout pour un prix moins élevé. A vous de voir.

****************************

Un processeur (aussi appelé microprocesseur ou CPU pour Central Processing Unit) est le coeur de l'ordinateur chargé de traiter et d'exécuter les instructions. On peut simplifier en disant qu'il est chargé d'exécuter les programmes de l'ordinateur.

Ce composant a été inventé en 1971 par Intel (avec le modèle 4004).

Le processeur est rythmé par une horloge (quartz) cadencée plus ou moins rapidement (on parle de fréquence d'horloge). A chaque impulsion d'horloge, le processeur lit l'instruction stockée généralement dans un registre d'instruction - une petite mémoire très rapide située dans le processeur en lui-même - et l'exécute. Dans une même gamme (et donc à architecture comparable) un processeur cadencé plus rapidement est plus efficace car il peut traiter les instructions plus rapidement.

Avec les dernières architectures, les fréquences n'augmentent plus aussi rapidement qu'avant. Les fabriquants axent plutôt leurs travaux sur l'amélioration du rendement et de la performance par watt, afin d'avoir des processeurs toujours plus performants, moins gourmands en énergie et du coup nécessitant moins de moyens pour dissiper leur chaleur.

Instructions

Le processeur ne sait communiquer qu'avec le reste de l'ordinateur via le langage binaire. Il ne comprend donc pas directement le code informatique que vous pourriez utiliser en suivant les cours de la section programmation de VIC.

Le code source doit à ce titre subir quelques transformations. Celles-ci sont effectuées par le compilateur, un programme convertissant le langage source en langage machine, seul code compréhensible par le processeur.

Format d'une instruction

Pour qu'un processeur puisse exécuter une instruction, encore faut-il qu'il sache de quelle instruction il s'agit et quelles sont les données sur lesquelles agir. C'est pourquoi une instruction sera stockée selon une méthode bien précise. On divise ainsi une instructions en deux codes :

- Le code opération, qui représente le type d'instruction (si il faut déplacer des données d'un registre à l'autre, faire une addition...)

- Le code opérande, qui représente les paramètres de l'instruction (adresse mémoire, constantes utilisées, valeurs, registres, etc.)

Principaux types d'instructions

Il existe différents types d'instructions. Les plus courants sont les suivants :

- Instructions d'opérations arithmétiques (addition, soustraction, division, multiplication)

- Instructions d'opérations logiques (OU, ET, OU EXCLUSIF, NON, etc...)

- Instructions de transferts (entre différents registres, entre la mémoire et un registre, etc...

- Instructions ayant rapport aux entrées et sorties.

- Instructions diverses ne rentrant pas dans les autres catégories (principalement des opérations sur les bits).

Etapes d'exécution d'une instruction

Lorsqu'un processeur a besoin d'exécuter des instructions, il le fait toujours dans l'ordre suivant :

- Recherche de l'instruction (fetch)

- Lecture de l'instruction

- Décodage de l'instruction

- Exécution de l'instruction

Taille des instructions

Les processeurs utilisent à ce jour majoritairement des instructions 64 bits (X86-64), la taille des instructions manipulées est passée de 32 à 64 bit, avec plusieurs avantages à la clé : un adressage maximal de la mémoire qui n'est plus limité à 4 Go comme c'était le cas en 32 bit, et une rapidité généralement accrue des applications en tirant partie (car plus de registres disponibles signifie qu'on aura généralement plus de place pour stocker des données au lieu d'utiliser la RAM avec un code optimisé).

Registres

Un registre est une petite mémoire de taille raisonnable (variant généralement de 32 à 128 bit). Les registres sont utilisés tout le temps, ils sont donc très importants. Nous avons vu plus haut qu'une instruction pouvait faire appel aux registres. L'avantage est que ce type d'opérations est beaucoup plus rapide que de faire appel à la mémoire vive, les registres étant internes au processeur, contrairement à la mémoire vive. Il existe différents types de registres, voici les principaux :

- Le registre d'instruction (RI) qui permet de stocker l'instruction qui va être exécutée.

- Le registre d'état qui permet de stocker des indicateurs sur l'état du système après l'exécution d'une instruction. Voici quelques indicateurs (qui peuvent changer d'appellation, le principe restant le même :

- C (pour carry) : vaudra 1 si une retenue est présente.

- V (pour oVerflow) : vaudra 1 en cas de dépassement de capacité (addition de deux chiffres positifs donnant un résultat négatif par exemple).

- N (pour Negative) : vaudra 1 si le résultat est négatif.

- Le registre PC (Program counter) qui stocke l'adresse de la prochaine instruction à exécuter.

Mémoire cache

Chaque processeur intègre une quantité variable de mémoire cache. Cette mémoire très rapide est indispensable pour bénéficier de bonnes performances dans les applications. Elle permet de stocker les données les plus fréquemment demandées par le processeur.

On distingue trois niveaux de cache :

On distingue trois niveaux de cache :

- Le cache L1 (cache de premier niveau) : La quantité intégrée est généralement faible (de 8 à 64 Ko généralement)

- Le cache L2 (cache de second niveau) : Cette quantité varie de 128 Ko à 1 Mo, ce cache est légèrement moins rapide que le cache L1

- Le cache L3 (cache de troisième niveau) : Ce cache (disponible sur certains processeurs) et peut vous permettre de gagner 10% de performances supplémentaires. Il est un peu plus lent que le cache L2 mais, en contrepartie, dispose d'une taille bien plus grande (12 Mo est une valeur courante).

Lorsqu'un processeur a besoin de lire des données, il va d'abord regarder si celles-ci se trouvent dans la mémoire cache. Si elles s'y trouvent, on parle de succès du cache (cache hit), dans le cas contraire d'échec du cache (cache miss) les données étant placées ensuite en cache à partir de la mémoire vive.

Il y a perte de temps en cas de cache miss car le processeur a regardé dans le cache pour rien. Le taux de réussite s'appelle le hit rate, le taux d'échec miss rate.

Afin d'augmenter les performances et donc de diminuer le miss rate, il existe différentes techniques ayant chacune leurs avantages et inconvénients. Outre différents algorithmes pouvant être implantés dans le programme, on parlera ici d'une technique matérielle, celle consistant à adopter une mémoire cache de type inclusive ou exclusive. La différence principale entre ces deux types de gestion du cache se trouve principalement dans leur manière de stocker les données. Lorsque le cache L1 est plein, il faut libérer de la place pour pouvoir placer dans le L1 la donnée que l'on vient de lire en mémoire vive.

Cache Exclusif

Il faut faire de la place dans le cache L1, on déplace donc une donnée (celle la moins récemment utilisée) et on la place dans le cache L2, puis ensuite on place la donnée provenant de la mémoire vive dans le cache L1.

Lorsqu'une donnée est présente dans le cache L2 mais pas dans le L1, on la fait remonter dans le L1 en permutant la donnée la moins récente du L1 avec la donnée du L2. Les caches L1 et L2 ne contiennent jamais les mêmes données (elles passent de l'un à l'autre des caches), on parle donc de cache exclusif. L'avantage est de pouvoir avoir une liberté sur la taille des caches (la taille efficace étant l'addition des tailles des caches des différents niveaux). Le désavantage de cette technique est que les performances du cache L2 sont réduites étant donné qu'il faut écrire une donnée dans le cache L1 à chaque fois qu'on récupère une donnée dans le L2.

Cache Inclusif

Lorsque la donnée ne se trouve ni dans le L1 ni dans le L2, on copie la donnée de la mémoire vive dans les deux niveaux de cache (L1 et L2). La ligne écrasée du cache L1 n'est pas déplacée dans le L2 car elle y est déjà.

A ce stade, le cache L2 contient des données supplémentaires par rapport au cache L1, cependant toutes les données qui sont présentes dans le cache L1 sont présentes dans le cache L2. On parle d'un cache inclusif. L'avantage majeur de ce type de cache est de ne pas avoir à réécrire la donnée dans le cache L1 en cas de cache hit en lecture dans le cache L2. Les performances du cache L2 sont donc supérieures. L'inconvénient majeur est la taille totale du cache efficace ainsi que la contrainte de taille des caches L1 et L2. Pour être efficace, cette technique doit être mise en oeuvre avec un cache L2 très grand devant la taille du cache L1.

Composition d'un processeur

Tous les processeurs sont composés de ces éléments :

- L'UAL (unité arithmétique et logique, aussi appelée ALU) : c'est l'unité de calcul qui gère ce qui porte sur des nombres entiers.

- La FPU (Floating Point Unit) est l'unité de traitement des nombres à virgules (aussi appelés nombres flottants).

- Le décaleur : il est le spécialiste des divisions et multiplications par deux. Son rôle est de décaler les bits vers la gauche ou vers la droite.

- Les registres

- Le circuit de données : son rôle est d'acheminer les données provenant de l'UAL vers les registres.

- La MMI (Mémoire de micro instructions) : cette zone du processeur contient toutes les instructions nécessaires à celui-ci pour comprendre les instructions du langage machine.

- Le SEQ (séquenceur) : cet organe traduit les instructions compliquées en instructions plus simples pour permettre au processeur de les traiter.

- L'unité de gestion des instructions : elle recueille les instructions demandées, les décode puis les envoie à l'unité d'éxécution.

- L'unité d'exécution : son rôle est d'exécuter les tâches que lui a envoyé l'unité d'instruction.

- L'unité de gestion des bus : elle permet de gérer les informations entrantes et sortantes.

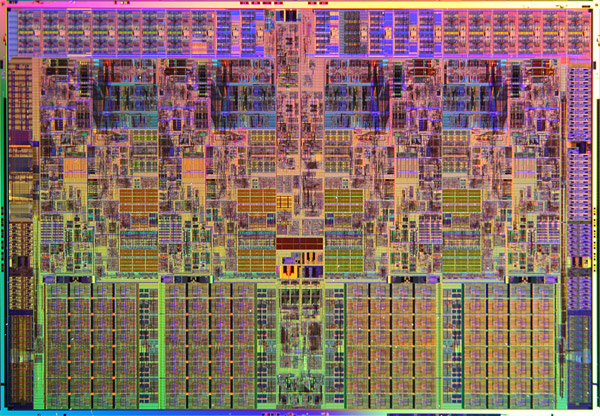

Die

Le core (ou die) d'un processeur est toute sa partie centrale contenant les unités de calcul, les registres et la mémoire cache. Voici à quoi il ressemble :

Optimisations des architectures

Le pipeline

Afin d'optimiser le rendement, la technique du pipeline est apparue sur les 386 d'Intel. Le pipeline permet de commencer à traiter l'instruction suivante avant d'avoir terminé la précédente via un mécanisme de "travail à la chaîne". L'inconvénient de cette technique est que plus le pipeline est profond (contient d'étapes) plus la perte de performances est importante si une erreur de prédiction survient. L'avantage de cette technique est qu'elle permet d'augmenter la fréquence du processeur plus facilement. L'inconvénient majeur de cette technique est qu'elle entraîne une baisse des performances à fréquence égale. Il y a également une augmentation du dégagement thermique et donc de la température du processeur. Pourquoi cette hausse de température ? Lorsque l'instruction doit être exécutée en un temps donné, quelle que soit la profondeur du pipeline, cette instruction sera toujours exécutée aussi rapidement. Plus il y a d'étages au pipeline, plus l'instruction doit être "découpée" en une quantité de "micro-instructions" qui seront exécutées en un temps très court, bien plus court que le temps nécessaire pour traiter l'instruction. Or, plus le pipeline comporte d'étages et plus le délai de traitement d'une "micro-instruction" doit être faible, ce qui nécessite généralement plus de transistors, ces transistors chauffent, ont besoin généralement de plus de courant pour fonctionner plus rapidement. Voilà une des causes du dégagement thermique supérieur des processeurs comportant un nombre important d'étages de pipeline.

L'architecture super scalaire

Cette astuce consiste à augmenter le nombre d'unités de traitement afin de traiter plusieurs instructions par cycle.

L'hyperthreading

Sous ce terme un peu barbare se cache une optimisation d'Intel apparue avec ses processeurs Pentiums 4.

Cette optimisation consiste à émuler des processeurs logiques. Le système d'exploitation croit qu'il dispose de plus de processeurs qu'il n'en a et gave de ce fait le processeur de plus d'instructions. Cela améliore son rendement.

Le multi-core (multi coeurs)

Suite à l'impossibilité de monter en fréquence, les deux fondeurs principaux ont commencé à implanter ce qu'on appelle le multicore.

Le multicore consiste à mettre plusieurs die (ce n'est pas tout à fait ça) dans un unique processeur afin de disposer de plusieurs processeurs de calcul. l'optimisation des performances passe désormais par l'ajout de coeurs et par l'optimisation du rendement.

Cette architecture est très efficace en multitâche, en monotâche elle ne vous fera rien gagner à moins d'augmenter les performances des coeurs (ajout de cache, hausse de fréquence...), c'est pourquoi l'efficacité par cycle est redevenue à la mode.

Mémoire cache non partagée

Avec ses premiers dualcore, Intel avait utilisé une technique plus rapide consistant à coller deux die côte à côte (pour simplifier). La mémoire cache était du coup deux fois plus grande, mais seule la moitié était utilisable pour chacun des processeurs.

Il y a 2 Mo de mémoire cache L2 au total mais chaque core ne peut utiliser qu'1 Mo de mémoire. Lorsqu'une application a besoin de beaucoup de mémoire cache, cette solution n'est pas optimale.

D'autre part, si les deux coeurs veulent dialoguer entre eux (et c'est là où se situait l'énorme goulôt d'étranglement), ils doivent passer par le bus principal (FSB). Les performances en multitâche sont donc bridées, même si Intel a augmenté la fréquence du FSB pour limiter les pertes de puissance.

Mémoire cache partagée

Conscient de ces problèmes, Intel a suivi AMD en adoptant une architecture plus robuste à cache partagé :

Les instructions spécialisées

Tous les processeurs apportent leur jeu d'instructions spécialisées. Elles permettent, lorsqu'elles sont exploitées par les compilateurs, d'accélérer le traitement de tâches comme la 3D par exemple. MMX, SSE, Vpro, etc. sont les noms de ces technologies.

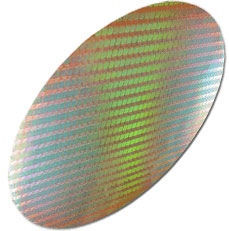

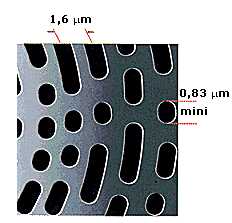

Fabrication d'un processeur

Les processeurs sont tous gravés sur des plaques appelées Wafers. Les différentes séries de processeurs n'ont pas forcément la même finesse de gravure (mesurée en micromètres (µm) ou nanomètres (nm)). Les processeurs actuels sont gravés en 0.045µ et 0.032µ (soit respectivement 45 et 32 nanomètres).

Diminuer la finesse de gravure permet de produire plus de processeurs à la fois sur un Wafer et permet donc d'abaisser leur coût de fabrication. Cette technique permet également de diminuer la consommation du processeur et donc la quantité de chaleur produite ce qui permet d'abaisser la consommation d'énergie et de monter plus haut en fréquence. Une finesse de gravure accrue permet également de loger plus de transistors dans le core (aussi appelé die) du processeur, et donc d'ajouter des fonctionnalités supplémentaires tout en gardant une surface aussi compacte que les générations précédentes.

Choisir un processeur

Il existe de nombreux processeurs. Dans le monde du PC, on distingue deux grands constructeurs : Intel, et AMD, ayant chacuns leurs domaines de prédilection. On différencie les processeurs par :

- Leur fréquence (vitesse de traitement maximale si vous préférez). Cette fréquence s'exprime en GHz (Giga-hertz). La fréquance s'obtient en multipliant la fréquence du FSB (Front Side Bus aussi appelé Bus système) par un coefficient multiplicateur. Plus elle est élevée, mieux c'est (dans une même famille de processeurs).

- Leur architecture interne : Nombre d'ALU, de FPU, architecture des mémoires caches.

- Leur quantité de mémoire cache (répartie sur 1, 2 ou 3 niveaux). Plus le cache est grand, mieux c'est.

- Leur mode de connexion à la carte-mère (appelé socket, dont le nombre de trous et l'appellation varient. En général on appelle un socket par son nombre de contacts, on parle alors de "socket 1150", par exemple, pour désigner un socket comportant 1150 contacts) :

La mémoire vive (aussi appelée RAM pour Random Acess Memory - mémoire à accès aléatoire) permet de stocker les informations dont l'ordinateur a besoin rapidement et dont il se sert souvent. Lorsqu

e vous ouvrez un programme, celui-ci est stocké dans la mémoire vive de votre PC, qui dispose d'un accès beaucoup plus rapide que le disque dur. Pourquoi ne pas avoir utilisé de la mémoire vive dans ce cas pour stocker les données ? C'est très simple : la mémoire vive est volatile. Une simple perte de courant et elle perd toutes ses informations ! De plus, son coût et son encombrement sont bien plus élevés que ceux d'un disque dur.

Fonctionnement de la mémoire vive (RAM)

La mémoire se présente sous forme de composants électroniques ayant la capacité de retenir des informations (les informations étant de typebinaire, 0 ou 1). Chaque "bit" mémoire est composé d'un transistor (qui permet de lire ou d'écrire une valeur) accouplé à un condensateur (qui permet de retenir l'état binaire : 1 quand il est chargé et 0 quand il est déchargé). La mémoire est organisée sous forme de lignes et de colonnes. A chaque intersection correspond un bit de mémoire. Voici la représentation d'un bit :

Les condensateurs se déchargent (leur tension diminue), il est nécessaire de les recharger pour éviter les pertes d'informations. On appelle cela le rafraîchissement. Une barrette de mémoire est constituée de trois éléments principaux :

- La mémoire proprement dite (en réalité plusieurs tableaux de bits mémoire)

- Un buffer (zone de tampon) entre la mémoire et le bus de données

- Le bus de données (qui est relié à certains pins (contacts) de la barrette et est en relation avec la carte-mère)

Temps d'accès, de lecture et d'écriture (timings)

L'accès à un bit de mémoire se fait suivant plusieurs étapes, chacune de ces étapes nécessitant un certain temps (appelé timing). Il y a plusieurs étapes, donc plusieurs temps (timings). Nous allons détailler chacun de ces timings (dont la valeur est indiqué en cycles dans le BIOS, un cycle correspondant à l'inverse de la fréquence. Plus la fréquence est élevée, plus le temps diminue. La relation exacte est la suivante :

T = 1/f, où f représente la fréquence du bus.

A 200 MHz, T est égal à 5 ns (nanosecondes).

- Le RAS precharge Time : c'est l'intervalle de temps nécessaire avant d'envoyer une autre commande RAS.

- Le RAS : c'est le temps nécessaire pour sélectionner une ligne.

- Le RAS to CAS : c'est le temps nécessaire pour passer du mode de sélection de lignes au mode de sélection de colonnes.

- Le CAS : c'est le temps nécessaire pour sélectionner une colonne

Lorsqu'on parle de timings mémoire on communique souvent les timings dans l'ordre suivant (même si ce n'est pas indiqué) :

- CAS

- RAS to CAS

- RAS precharge

- RAS

Avoir des timings faibles permet de gagner en performances. Attention cependant à ne pas trop forcer, car vous risqueriez de vous retrouver avec un système instable. Dans tous les cas, avec des timings configurés de manière optimale, vous gagnerez environ 5% de performances par rapport à des timings laissés par défaut. Le jeu en vaut-il la chandelle ? à vous de voir ! La qualité de fabrication du circuit imprimé des barrettes entre en jeu (PCB pour Printed circuit board) mais aussi la qualité de fabrication des puces mémoires se trouvant sur le PCB (et généralement noires).

Types de mémoire

Mémoire vive

La mémoire vive (ou RAM pour Random Access Memory): cette mémoire perd ses données si elles ne sont pas rafraîchies régulièrement, on appelle ce type de mémoire de la mémoire dynamique.

Mémoire morte

La mémoire morte (ou ROM pour Read Only Memory) : cette mémoire ne perd pas ses données (sauf par des techniques de réécriture, comme le flashage pour les mémoires flash), même si elle n'est pas rafraîchie. On appelle les mémoires n'ayant pas besoin d'être rafraîchies pour conserver leurs informations des mémoires statiques. Elles sont composées de bascules électroniques et permettent de stocker plus d'informations à espace identique comparé aux mémoires dynamiques. Il en existe de différents types :

- ROM : on gravait les données binaires sur une plaque de silicium grâce à un masque. Il était impossible de reprogrammer cette mémoire. Ce genre de mémoire n'est plus utilisé aujourd'hui.

- PROM (Programmable Read Only Memory) : Ces mémoires sont constituées de fusibles pouvant être grillés grâce à un appareil qui envoie une forte tension (12V) dans certains fusibles. Un fusible grillé correspond à un 0, et un fusible non grillé à un 1. Ces mémoires ne peuvent être programmées qu'une fois.

- EPROM (Erasable Programmable Read Only Memory) : Même principe que l'EPROM, sauf que cette mémoire est effaçable. Lorsqu'on la met en présence de rayons ultra-violets d'une longueur d'onde précise, les fusibles sont reconstitués, et tous les bit reviennent à une valeur de 1. C'est pour cette raison que l'on qualifie ce type de PROM d'effaçable.

- EEPROM (Electrically Erasable read Only Memory) : Ce sont aussi des PROM effaçables, par un courant électrique toutefois. Elles peuvent être effacées même lorsqu'elles sont en position dans l'ordinateur. Ces mémoires sont aussi appelées mémoires flash, et donc voilà pourquoi on appelle flashage l'opération qui consiste à flasher une mémoire EEPROM.

Fréquences et types de RAM

De nombreux types de mémoire se sont succédés, disposant de différents formats. Aujourd'hui, les barrettes sont toutes au format DIMM (Dual Inline Memory Module) : il n'est pas nécessaire de les apparier pour faire fonctionner le système.

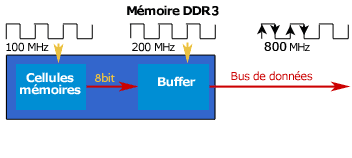

Aujourd'hui, toutes les mémoires sont de type SDRAM. La SDRAM (synchronous dynamic random access memory) est apparue en 1997. Elle permet une lecture des données synchronisée avec le bus de la carte-mère, contrairement aux mémoires EDO et FPM qui étaient asynchrones. La SDRAM permet donc de supprimer les temps d'attente dus à la synchronisation avec la carte-mère et permet d'avoir des temps d'accès de moins de 10 nanosecondes. Ces barrettes contiennent les cellules stockant la mémoire, et un buffer (zone tampon) entre la mémoire proprement dite et les entrées/sorties :

La mémoire SDRAM n'a cessé d'évoluer et existe en différentes versions que nous allons retracer (en omettant les premières versions de la SDRAM, trop anciennes). Aujourd'hui, les PC récents sont dotés de DDR-3.

Calcul de la bande passante mémoire

La bande passante est la quantité de données qui peuvent être échangées par seconde, au maximum. Elle se calcule de la façon suivante : Bande passante (Go/s) = (Fréquence de sortie (mHz) * Nombre de bits échangés) / 8000. (8 bits = 1 octet)

Fréquences

Les fréquences internes sont plus ou moins limitées. Des artifices ont alors été inventés pour améliorer la bande passante tout en conservant les fréquences internes qui se limitent pour l'heure à environ 300MHz.

DDR

La DDR (ou SDRAM DDR pour Double Data Rate) est apparue pour palier aux fréquences qui n'augmentaient plus. Variante de la première SDRAM mais comportant 186 broches, elle prend en compte les fronts montants et descendants du bus système afin de doubler la bande passante mémoire disponible. Voici la constitution principale d'une barrette mémoire de DDR :

| Type de mémoire | Appellation commerciale | Fréquence mémoire | Fréquence d'entrées/sorties | Bande passante |

|---|---|---|---|---|

| DDR200 | PC1600 | 100 MHz | 100 MHz | 1,6 Go/s |

| DDR266 | PC2100 | 133 MHz | 133 MHz | 2,1 Go/s |

| DDR333 | PC2700 | 166 MHz | 166 MHz | 2,7 Go/s |

| DDR400 | PC3200 | 200 MHz | 200 MHz | 3,2 Go/s |

| DDR433 | PC3500 | 217 MHz | 217 MHz | 3,5 Go/s |

| DDR466 | PC3700 | 233 MHz | 233 MHz | 3,7 Go/s |

| DDR500 | PC4000 | 250 MHz | 250 MHz | 4 Go/s |

| DDR533 | PC4200 | 266 MHz | 266 MHz | 4,2 Go/s |

| DDR538 | PC4300 | 269 MHz | 269 MHz | 4,3 Go/s |

| DDR550 | PC4400 | 275 MHz | 275 MHz | 4,4 Go/s |

| DDR600 | PC4800 | 300 MHz | 300 MHz | 4,8 Go/s |

DDR-2

La différence majeure entre la DDR et la DDR2 est, outre le nombre de broches qui passe à 240, que la fréquence du bus est double de celle du groupe de cellules mémoires. A chaque fois que les cellules mémoire effectuent un cycle, on peut transférer quatre bits de données par cellule, au lieu de deux pour la DDR. à fréquence des cellules mémoires égale, la DDR2 a une bande passante deux fois plus élevée.

Bien que les fréquences aient été améliorées, les temps d'accès ont, eux, été augmentés, ce qui fait que les premières barrettes de DDR-2 étaient moins performantes que les meilleures barrettes de DDR. La DDR-2 consomme également moins d'énergie avec une tension revue à 1.8 volt.

| Type de mémoire | Appellation commerciale | Fréquence mémoire | Fréquence d'entrées/sorties | Bande passante |

|---|---|---|---|---|

| DDR2-400 | PC2-3200 | 100 MHz | 200 MHz | 3,2 Go/s |

| DDR2-533 | PC2-4300 | 133 MHz | 266 MHz | 4,3 Go/s |

| DDR2-667 | PC2-5300 | 166 MHz | 333 MHz | 5,3 Go/s |

| DDR2-675 | PC2-5400 | 168 MHz | 337 MHz | 5,4 Go/s |

| DDR2-800 | PC2-6400 | 200 MHz | 400 MHz | 6,4 Go/s |

| DDR2-1066 | PC2-8500 | 266 MHz | 533 MHz | 8,5 Go/s |

| DDR2-1100 | PC2-8800 | 280 MHz | 560 MHz | 8,8 Go/s |

| DDR2-1200 | PC2-9600 | 300 MHz | 600 MHz | 9,6 Go/s |

DDR-3

Apparue en 2007, la DDR-3 va encore plus loin que la DDR-2 en transmettant non plus 4 mots par cycle mais 8, doublant les débits par rapport à la DDR-2. Les barrettes de DDR-3 comportent 240 broches et fonctionnent avec une tension encore amoindrie : 1.5 volt.

| Type de mémoire | Appellation commerciale | Fréquence mémoire | Fréquence d'entrées/sorties | Bande passante |

|---|---|---|---|---|

| DDR3-800 | PC3-6400 | 100 MHz | 400 MHz | 6,4 Go/s |

| DDR3-1066 | PC3-8500 | 133 MHz | 533 MHz | 8,5 Go/s |

| DDR3-1333 | PC3-10600 | 166 MHz | 666 MHz | 10,7 Go/s |

| DDR3-1600 | PC3-12800 | 200 MHz | 800 MHz | 12,8 Go/s |

| DDR3-1800 | PC3-14400 | 225 MHz | 900 MHz | 14,4 Go/s |

| DDR3-2000 | PC3-16000 | 250 MHz | 1000 MHz | 16 Go/s |

| DDR3-2133 | PC3-17000 | 266 MHz | 1066 MHz | 17 Go/s |

Fabrication d'une barrette mémoire

Le processus de fabrication d'une barrette mémoire est d'autant plus strict que la mémoire est à hautes performances. Voici une vidéo sympatique de la marque CRUCIAL qui permet de voir toutes les étapes de la fabrication d'une barrette mémoire hautes performances :

La carte graphique est l'un des rares périphériques reconnus par le PC dès l'initialisation de la machine. Elle permet de convertir des données numériques brutes en données pouvant être affichées sur un périphérique destiné à cet usage (écran, vidéo projecteur, etc...). Son rôle ne se limite cependant pas à ça puisqu'elle décharge de plus en plus le processeur central des calculs complexes 3D et ce au moyen de diverses techniques que nous allons voir plus bas.

Une carte graphique est composée de quatre éléments principaux :

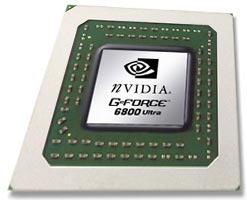

- Le GPU (Graphical processing unit) : c'est le processeur central de la carte graphique. Aujourd'hui les GPU possèdent des fonctions très avancées. Chaque génération de GPU apporte son lot d'innovations technologiques, qui sont plus ou moins utilisées dans les jeux. Le principal intérêt est de soulager le processeur central, d'augmenter la qualité des images tout en faisant chuter le moins possible les performances. Voici à quoi peut ressembler un GPU sans son ventirad (le ventirad est le couple radiateur + ventilateur) :

- Le RAMDAC (Random access memory digital analog converter) : cette puce est destinée à convertir les données numériques en données analogiques compréhensibles par les écrans cathodiques. La fréquence du RAMDAC nous renseigne sur le nombre maximal d'images par seconde que la carte peut afficher au maximum (même si sa puissance théorique est supérieure, elle sera limitée par le RAMDAC si celui-ci est cadencé trop faiblement). Rassurez-vous, les cartes ne sont jamais bridées par ce composant. On parle souvent de fréquence de rafraîchissement.La fréquence de rafraîchissement est mesurée en Hz (hertz) et va déterminer le nombre maximal d'images par seconde qui pourront être affichées. C'est pourquoi si vous avez un écran qui ne rafraîchit votre image que 60 fois par seconde, il est inutile d'avoir une carte graphique qui en débite 150, vous ne verrez pas la différence. Autant donc augmenter la qualité de l'image.Nous verrons plus bas quelles sont les techniques permettant d'augmenter la qualité des images.

- La mémoire vidéo : variant généralement de 16 à 512 Mo, elle est utilisée pour stocker les textures (généralement sous formes d'images). Plus la taille de cette mémoire est importante, mieux c'est. Attention de ne pas non plus tomber dans l'inutile : 16 Mo (mémoire partagée, utilisée notamment par la technologie Turbo Cache que nous allons détailler plus bas) sont largement suffisants en utilisation bureautique et multimédia. Les jeux en revanche ne se satisferont pas d'une quantité aussi limitée, même si la mémoire vive vient en renfort avec cette technologie. La largeur du bus de la mémoire joue également beaucoup : un bus de 128 bit de largeur sera généralement moins performant qu'un 256 bit.Aujourd'hui, il existe deux types de mémoire vidéo :

- La mémoire GDDR 2 (DDR pour Double Data Rate), exploitant les fronts montants et descendants de la mémoire, autrement dit la bande passante est doublée par rapport à la SD-RAM à même fréquence. On trouve plutôt ce type de mémoire sur les cartes graphiques bas de gamme.

- La mémoire GDDR 3 : presque identique à la GDDR 2, elle gagne en fréquence et sa tension d'alimentation diminue. Elle est toujours utilisée même dans les cartes graphiques les plus haut de gamme.

- Les éventuelles entrées-sorties vidéos (VGA qui sert à relier les écrans cathodiques, DVI pour les écrans plats, et une éventuelle sortie TV généralement au format S Vidéo...). La plupart des cartes possèdent maintenant une sortie TV, qui permet de regarder des DVD sur sa télé par exemple. La connectique de sortie est au format S-vidéo, avec, souvent, un adaptateur S-vidéo/composite. Quelques cartes possèdent aussi un tuner vidéo, qui permet de regarder la télé sur son PC, ou encore un port DVI en plus du port VGA. Le port DVI est numérique et ne nécessite pas la traduction des données par le RAMDAC. Équipée de telles cartes, l'ordinateur devient une véritable télé associée à un magnétoscope. Certaines cartes disposent de plusieurs sorties VGA pour pouvoir brancher deux écrans sur son ordinateur: L'intérêt du DUAL HEAD est de disposer d'un affichage plus étendu sous Windows. On peut ainsi ouvrir plus de programmes tout en se repérant mieux.

Performances graphiques :

Les performances d'une carte graphique dépendent en grande partie du processeur central. En effet, le processeur indique à la carte graphique tout ce qu'elle doit calculer. Cependant celui-ci devant aussi gérer les autres paramètres du jeu, il se peut qu'il ne fournisse pas assez d'informations, et alors la carte graphique doit attendre que le processeur ait terminé de mouliner. Il faut un processeur bien adapté à la carte vidéo afin d'éviter ce genre de piège. Mais il ne sert à rien d'avoir un processeur dernier cri avec une carte graphique d'entrée de gamme en utilisation ludique.

Plus la résolution augmente, plus le travail de la carte graphique sera important.

Plus la résolution augmente, plus le travail de la carte graphique sera important.

Les ports de connexion à la carte-mère :

La plupart des cartes graphiques se placent sur les ports AGP (pour Accelerated Graphic Port) et PCI Express. Le port AGP est apparu avec le Pentium II d'Intel en 1997. Celui-ci est totalement différent d'un port PCI tant physiquement que par sa vitesse. En effet le port AGP permet de partager la mémoire vive du PC quand la mémoire de la carte graphique est saturée. Cependant cette méthode d'accès est nettement plus lente que celle de l'accès à la mémoire de la carte graphique. On différencie trois normes d'AGP :

- l'AGP 2X (500 Mo par seconde)

- l'AGP 4X (1 Go par seconde)

- l'AGP 8X (2 Go par seconde)

Les cartes graphiques PCI Express :

Le PCI Express est la norme qui a désormais remplacé l'AGP sur le marché des cartes graphiques. Plus rapide, existant en de nombreux formats, il remplace avantageusement les ports PCI et AGP. Il existe en différents débits :

Quelques technologies d'amélioration de qualité ou de performances :

Les constructeurs sont de plus en plus nombreux à vouloir ajouter des fonctionnalités supplémentaires à leurs produits. Cela va de la simple optimisation logicielle (au niveau des drivers) à des fonctions matérielles beaucoup plus puissantes. Nous allons en voir quelques unes et détailler pour chacune leurs avantages et inconvénients.

L'antialiasing :

Sous ce terme un peu barbare se cache en fait une technologie destinée à améliorer la qualité de l'image, et notamment de ses arrêtes. Qui n'a en effet pas déjà pesté devant les images "en escaliers" ? l'antialiasing permet d'y remédier plus ou moins bien. Les cartes graphiques intègrent plusieurs niveaux d'antialiasing, ces niveaux peuvent aller de 2X à 32X. Plus le niveau choisi est élevé, meilleure est la qualité, mais plus les performances sont diminuées. Voici un aperçu de ce que peut donner une image sans puis avec antialiasing :

Le filtrage anisotrope :

L'antialiasing, vous pourrez le constater, provoque un léger effet de flou, surtout lorsque les arrêtes à retravailler sont lointaines. Le filtrage anisotrope vient palier à ce défaut. Il a été surtout conçu pour palier les défauts d'affichage des textures lointaines en les rendant plus nettes. Le filtrage anisotrope propose lui aussi différents niveaux de filtrage qui vont généralement de 2 à 16X. Plus le niveau de filtrage est élevé, plus les performances chutent (dans une moindre mesure qu'avec l'antialiasing toutefois). Voici ce que ça donne en images :

La technologie Turbo cache :

Implantée par NVIDIA sur ses cartes graphiques d'entrée de gamme, la technologie turbo cache est destinée à réduire le coût de production des cartes graphiques d'entrée de gamme mais aussi à récupérer des parts de marché sur les chipsets graphiques intégrés (qui offrent des performances généralement moindres que les cartes d'entrée de gamme). Cette technique consiste à n'implanter qu'une petite quantité de mémoire vive sur la carte graphique. Elle piochera alors d'abord sur sa mémoire disponible, et si elle en a besoin de plus, ira piocher dans la mémoire vive du PC. L'accès à la mémoire vive étant bien entendu nettement plus lent que l'accès à la RAM de la carte graphique. Il en résulte donc des performances moindres mais un coût qui l'est également. Cette technologie convient donc parfaitement pour ce à quoi elle est destinée, c'est à dire l'entrée de gamme. Les cartes équipées de la technologie turbo cache embarquent de 16 à 64 Mo de mémoire, mais attention aux emballages souvent estampillés "128 Mo" par exemple (les emballages affichant la taille de la mémoire que la carte peut s'accaparer au total).

Le SLI (Scalable Link Interface) :

Le SLI est une technique que l'on trouvait sur les très anciennes cartes 3DFX aujourd'hui disparues. Cette technique a depuis été remise au goût du jour par NVIDIA. Le SLI consiste à utiliser deux cartes graphiques qui vont se répartir le travail. Des algorithmes sont là pour répartir équitablement la charge entre les deux cartes, c'est à dire qu'une carte ne pourra calculer que 10% de la surface totale d'une image si celle-ci est gourmande en calculs, l'autre carte se chargeant des 90 % restants. Le bénéfice de cette technologie est surtout très important dès que l'on utilise les effets de qualité disponibles (antialiasing et filtrage anisotrope). Il permet de retarder la baisse de performances et permet au système d'être de plus en plus limité par le processeur du PC (l'évolution des processeurs graphiques étant généralement plus rapide).

************************

Le disque dur est l'organe du PC servant à conserver les données de manière permanente, même lorsque le PC est hors tension, contrairement à la mémoire vive, qui s'efface à chaque redémarrage de l'ordinateur, c'est la raison pour laquelle on parle de mémoire de masse.

Le disque dur est généralement l'élément le plus faible de l'ordinateur, celui qui bride le plus les performances globales d'un PC. C'est pourquoi son choix est crucial si vous ne souhaitez pas vous retrouver avec un PC dernier cri pourtant pachydermique.

Un disque dur est constitué de plusieurs disques rigides en métal, verre ou en céramique appelés plateaux et empilés les uns sur les autres avec une très faible distance d'écart.

Les plateaux tournent autour d'un axe (entre 4000 et 15000 tours par minute) dans le sens inverse des aiguilles d'une montre.

Les données sont stockés sur le disque dur sous forme analogique sur une fine couche magnétique de quelques microns d'épaisseur recouverte d'un film protecteur. Un DSP (digital signal processor) se charge de la conversion des données analogiques en données numériques compréhensibles par l'ordinateur (0 ou 1, les bit).

Les plateaux tournent autour d'un axe (entre 4000 et 15000 tours par minute) dans le sens inverse des aiguilles d'une montre.

Les données sont stockés sur le disque dur sous forme analogique sur une fine couche magnétique de quelques microns d'épaisseur recouverte d'un film protecteur. Un DSP (digital signal processor) se charge de la conversion des données analogiques en données numériques compréhensibles par l'ordinateur (0 ou 1, les bit).

La lecture et l'écriture se font grâce à des têtes de lecture/écriture situées de part et d'autre de chacun des plateaux et fixées sur un axe. Ces têtes sont en fait des électroaimants qui se baissent et se soulèvent (elles ne sont qu'à 15 microns de la surface, séparées par une couche d'air provoquée par la rotation des plateaux) pour pouvoir lire l'information ou l'écrire.

Cependant, les têtes ne peuvent se déplacer individuellement et seulement une tête peut lire ou écrire à un moment donné. Un cylindre correspond donc à l'ensemble des données situées sur une même colonne parmi tous les plateaux.

L'ensemble de cette mécanique de précision est contenue dans un boitier totalement hermétique, car la moindre particule peut détériorer l'état de surface du disque dur.

Les données d'un disque dur sont inscrites sur des pistes disposées en cercles concentriques autour de l'axe de rotation. Leur nombre varie en fonction du type de matériaux utilisés pour les plateaux et la couche magnétique. En simplifiant, le disque dur s'organise en plateaux, cylindres et secteurs. On appelle cylindre l'ensemble des pistes réparties sur les faces de chaque plateau et situées à la même distance de l'axe de rotation :

Chaque piste est numérotée. La numérotation débute par 0 et commence à l'extérieur du plateau. Les pistes sont à leur tour divisées en petites portions appelées secteurs. Leur nombre est déterminé en usine lors d'une phase appelée formatage physique. La numérotation des secteurs, elle, débute à 1. Cette organisation permet à l'ordinateur de localiser sans ambiguïté une zone du disque. L'adresse sera du type : Plateau 1 face intérieure, Cylindre (piste) 4 , secteur 12.

On appelle cluster la zone minimale que peut occuper un fichier sur le disque. Le système d'exploitation utilise des blocs qui sont en fait plusieurs secteurs (entre 1 et 16 secteurs). Un fichier minuscule devra donc occuper plusieurs secteurs (un cluster, taille minimum gérée par Windows).

Un disque dur se différencie par :

- Sa capacité exprimée en Go

- Sa densité exprimée en Go par plateau

- Sa vitesse de rotation exprimée en tours minutes

- Son temps d'accès exprimé en millisecondes

- Son interface, IDE, SCSI ou SATA

- Son taux de transfert moyen exprimé en Mo par seconde

Vitesse angulaire et vitesse linéaire :

Quand on dit qu'un disque tourne à 5400 trs/min on parle de vitesse angulaire (1 tour = 1 angle de 360 °), cette vitesse est par définition constante. Par contre la vitesse linéaire varie en permanence en fonction de la position des têtes de lecture/écriture du disque par rapport à son centre. Plus les têtes s'éloignent du centre, plus la vitesse linéaire augmente. Plus la vitesse linéaire est grande, plus le débit est important.

Une donnée située prés du centre du disque dur va donc être lue moins vite qu'une donnée située au bord. C'est ainsi que le débit maximum du media du bigfoot est quasi le même que celui de disques durs tournant à 7200 tours tout en tournant 2 fois moins vite.

Ce qui est dommage, c'est que l'on ne fait plus de disques durs 5 pouces 1/4 à cause d'un problème d'inertie.

Une donnée située prés du centre du disque dur va donc être lue moins vite qu'une donnée située au bord. C'est ainsi que le débit maximum du media du bigfoot est quasi le même que celui de disques durs tournant à 7200 tours tout en tournant 2 fois moins vite.

Ce qui est dommage, c'est que l'on ne fait plus de disques durs 5 pouces 1/4 à cause d'un problème d'inertie.

La densité d'informations :

La densité est la quantité d'informations que vous pouvez stocker sur une surface donnée. Elle n'influence que le débit du disque. Il ne faut pas se leurrer : un disque dur avec une très grande densité et une vitesse de rotation plus faible ira généralement plus vite qu'un autre qui a 10 ans et qui tourne à 7200 tours par minute. La difficulté de maîtrise de l'inertie fait que les constructeurs préfèrent augmenter la densité d'informations pour augmenter les performances. Le débit des disques durs a donc été multiplié par 50 avec une vitesse de rotation multipliée seulement par 4.

Les informations sur un disque dur sont stockées généralement longitudinalement :

Pour pouvoir stocker toujours plus d'informations, il a cependant fallu trouver un autre moyen de stockage plus performant. En effet le stockage longitudinal commençait à atteindre ses limites physiques. Les données sont donc, sur les disques durs les plus récents, stockées verticalement. Il en ressort une densité d'informations accrue.

Le temps d'accès :

C'est le temps moyen que mettent les têtes de lecture pour trouver les informations. Il est défini comme suit : Temps d'accès = Temps de latence + Temps d'accès aux données. Le temps de latence dépend uniquement de la vitesse de rotation du disque, puisqu'il représente le temps nécessaire pour trouver des données suite à un changement de piste (si la donnée se trouve un tour ou un quart de tour plus loin par exemple).

La faible évolution du temps d'accès entre les années 90 et nos jours est un problème d'inertie (énergie que vous devez dépenser pour arrêter un objet en mouvement).

Énergie cinétique = 1/2*[Masse * (Vitesse)²]

En augmentant légèrement la vitesse, l'inertie augmente exponentiellement ce qui rend la maîtrise de la mécanique difficile. On pourrait fabriquer des disques plus petits pour diminuer la masse des plateaux et des têtes, mais la vitesse linéaire diminuerait. Bref, c'est l'impasse. Il vaut mieux alors se tourner vers les disques durs SCSI qui offrent des temps d'accès de 3 ms pour certains.

Les interfaces ( modes de communications) :

Il existe trois interfaces pour disques durs : l'interface IDE, SATA et SCSI.

L'interface IDE :

L'IDE est une interface qui permet de connecter jusqu'à 4 unités simultanément ( disque dur, lecteur cd, etc...). l'IDE a beaucoup évolué depuis quelques années, son débit ou taux de transfert n'a cessé d'augmenter. En effet, au à ses débuts, l'IDE était d'une lenteur ridicule face au SCSI. Les dernières versions de l'IDE (UDMA 133) peuvent atteindre 133 Mo/s au maximum.

Spécificités de L'IDE :

- Vitesse de rotation maximale : 7200 tours.

- Taux de transfert Maximum : 133 Mo par seconde.

- Taux de transfert jusqu'à 60 Mo par seconde pour le disque le plus rapide

- Temps d'accès de 8 ms pour le disque le plus rapide

- Nombre maximum de périphériques gérés : 4 sans carte contrôleur. Les 4 disques durs doivent se répartir 133 Mo/s au maximum, ce qui fait qu'avec deux disques durs en raid 0 vous avez pratiquement saturé l'interface.

Avantage pour les disques durs IDE, ils coûtent bien moins cher à capacité égale que leurs homologues SCSI. Sachez que 150 MO par seconde suffisent largement pour toutes les applications. leur principal inconvénient est l'instabilité de leur taux de transfert et leur temps d'accès bien trop important, ce qui limite leurs performances.

L'interface SATA :

L'interface SATA (pour Serial ATA) est une évolution de l'IDE. La transmission des données se fait par un bus série et non parallèle, ce qui explique les faibles dimensions des nappes de ces disques durs. Le débit maximum que peut atteindre cette interface est de 300 Mo par seconde pour le moment (révision Sata II, contre 150 Mo/s pour la première version du Serial ATA).

L'interface serial ATA marque un progrès notable par rapport à l'IDE, même si les performances à vitesse de rotation identique stagnent en raison d'une mécanique identique à celle des disques IDE pour la plupart des disques vendus. Le Sata dispose cependant de nombreux avantages :

- 7 Fils seulement permettent de communiquer avec un disque dur SATA (contre 80 pour les dernières nappes ide). La principale raison à cela vient du fait que le Serial ATA utilise un bus série au lieu de parallèle. Le câble est donc largement plus compact et permet de mieux faire circuler l'air dans le PC.

- Les disques durs peuvent désormais être branchés et débranchés à chaud (hot plug)

- Chaque disque est connecté sur un port Sata de la carte-mère, il n'y a donc plus de schéma maître/esclave à prendre en compte.

- Les vieux disques IDE peuvent être réutilisés en utilisant un adaptateur et êtres connectés via l'interface SATA.

L'interface SCSI :

L'histoire du SCSI commence en 1965. Le SCSI est une interface qui permet la prise en charge d'un nombre plus important d'unités (disques durs, CD-ROM, etc..., que l'IDE).

Elle est surtout utilisée pour sa stabilité au niveau du taux de transfert.

C'est un adaptateur SCSI (carte adaptatrice sur un emplacement PCI ou ISA) qui se charge de la gestion et du transfert des données.

Le processeur central est alors déchargé de toute commande, ce qui lui permet de s'atteler à une autre tâche simultanément. Leprocesseur ne fait que dialoguer avec la carte SCSI. Ainsi chaque contrôleur SCSI a ses propres caractéristiques, le BIOS du PC n'a donc aucune emprise sur l'interface SCSI, car elle possède elle-même son propre BIOS.

Il est toutefois possible d'optimiser l'adaptateur en faisant évoluer le bios de la carte SCSI.

Elle est surtout utilisée pour sa stabilité au niveau du taux de transfert.

C'est un adaptateur SCSI (carte adaptatrice sur un emplacement PCI ou ISA) qui se charge de la gestion et du transfert des données.

Le processeur central est alors déchargé de toute commande, ce qui lui permet de s'atteler à une autre tâche simultanément. Leprocesseur ne fait que dialoguer avec la carte SCSI. Ainsi chaque contrôleur SCSI a ses propres caractéristiques, le BIOS du PC n'a donc aucune emprise sur l'interface SCSI, car elle possède elle-même son propre BIOS.

Il est toutefois possible d'optimiser l'adaptateur en faisant évoluer le bios de la carte SCSI.

Voici les principales normes SCSI actuelles avec leur débit :

- Ultra Wide SCSI-2 : 40 Mo/s maximum

- Ultra2 Wide SCSI : 80 Mo/s maximum

- Ultra3 SCSI : 160 Mo/s maximum

- Ultra320 SCSI : 320 Mo/s maximum

La différence principale entre l'IDE et le SCSI, est que le SCSI a besoin d'une carte pour fonctionner. On appelle cette carte une carte contrôleur SCSI. Cette carte prend en charge certaines opérations qui sont habituellement traitées par le processeur, ce qui économise les ressources par rapport à L'IDE et permet d'augmenter légèrement les performances des autres applications. D'autre part, le SCSI peut gérer jusqu'à 7 périphériques au lieu de 4 pour l'IDE. Mais il y a d'autres différences : le SCSI ne communique pas par le schéma maître-esclave mais par des numéros différents attribués à chacun des périphériques. Il faut ensuite fermer la chaîne par une "prise", pour indiquer à la carte qu'il n'y a plus de périphérique connecté.

Le cache :

Pour pallier aux performances stagnantes des disques durs, les constructeurs leurs ont adjoint un cache. Ce cache est présent depuis bien longtemps dans les disques durs. Il peut atteindre désormais 16 Mo aujourd'hui. Le cache sert de relais entre le disque dur et le processeur. Plus sa capacité est élevée, mieux c'est. Attention, cela ne signifie pas pour autant qu'un disque sera plus performant qu'un autre d'une marque concurrente !

Le NCQ :

Le NCQ est une technologie destinée à améliorer les performances des disques durs. Cette technique permet de réorganiser l'ordre des requêtes envoyées au disque dur pour que celui-ci récupère les données en faisant le moins de tours possibles pour récupérer les données demandées (ce qui se fait donc plus rapidement). Cette technologie n'est efficace que si vous ne parcourez pas un seul gros fichier non fragmenté sur le disque et est implantée dans les chipsets les plus récents :

Le fluid dynamic bearing :

Le fluid dynamic bearing (FDB) consiste à placer l'axe de rotation du disque dans un bain d'huile et non simplement dans des billes en acier. La première amélioration perçue est le bruit qui diminue significativement. L'autre amélioration majeure est la durée de vie accrue de ce type de matériel : les billes pouvant se creuser légèrement au bout de longues heures d'utilisation, la précision du disque dur peut en être affectée.

L'AAM (automatic acoustic management) :

L'AAM est un mode qui va vous permettre de gagner en nuisances sonores et en durée de vie pour votre disque dur en diminuant l'accélération et la décélération des têtes de lecture. Cela peut nuire énormément les temps d'accès aux données, c'est pourquoi si vous vous plaignez du manque de performances de votre PC je vous déconseille d'utiliser cette technique qui risquerait de le ralentir encore plus.

Le mode bloc des disques durs :